Coded Bias menunjukkan AI dan machine learning tidaklah bebas bias seperti yang digembar-gemborkan. Era perbudakan, ketika manusia dicap dan dilabeli, seakan kembali hadir. Tapi caranya kali ini halus dan bahkan dianggap keren.

KECERDASAN buatan (AI—artificial intelligence) digembar-gemborkan netral. Pemelajaran mesin (machine learning) digaung-gaungkan bebas bias. Algoritme dipuja-pujikan objektif. Begitulah kata para ksatria teknologi kiwari. Semua itu, kata mereka, akan menyelesaikan problem ketidakobjektifan dan kerentanan manusia dalam menangani segala bidang kehidupan dengan efisien.

Tapi, benarkah demikian?

Joy Boulamwini, mahasiswa doktoral (kini peneliti) Media Lab, Institut Teknologi Massachusetts (MIT), menemukan jawabannya ketika tengah mengerjakan proyek di kampusnya. Perangkat lunak pengenalan wajah yang ia gunakan tak mampu mendeteksi wajah gelapnya. Sejak penemuan itu, dia mulai meneliti banyak perangkat lunak sejenis buatan raksasa-raksasa teknologi seperti IBM, Amazon, dan Microsoft. Semua perangkat lunak itu ternyata hanya efektif dalam mendeteksi wajah lelaki ketimbang perempuan dan wajah kulit putih ketimbang kulit berwarna.

Boulamwini menemukan bias gender dan ras pada teknologi-teknologi yang kerap diklaim netral dan objektif itu. Tapi, dia tak berhenti di situ. Dia menelusuri lebih jauh. Persoalan ini tak terbatas pada perangkat lunak pengenalan dan analisis wajah tapi pada hampir seluruh teknologi yang memanfaatkan algoritme dan mahadata (big data), seperti AI dan machine learning.

Dia menuliskan hasil penelitiannya, yang kemudian dikutip banyak media arus utama. Dia berbicara di forum TED-Talk. Dia juga mendapati bahwa ternyata tak sedikit orang sepertinya—yakni mereka yang bekerja di bidang teknologi—memiliki kecemasan yang sama. Bias gender dan ras telah tertanam di dalam AI dan machine learning, yang kini makin memengaruhi banyak aspek dalam kehidupan manusia. Masa lalu manusia yang kelam (diskriminasi, perbudakan, rasisme) tengah diinjeksikan ke dalam teknologi-teknologi modern yang katanya keren itu.

Perjalanan Boulamwini kemudian direka ulang sutradara dokumenter Shalini Kantayya dalam Coded Bias. Kantayya mulai dikenal luas melalui Catching the Sun, film dokumenter tentang perjuangan orang-orang biasa membangun pembangkit listrik tenaga surya. Catching the Sun masuk dalam daftar film pilihan The New York Times pada 2016 dan ditayangkan oleh Netflix pada Hari Bumi tahun yang sama.

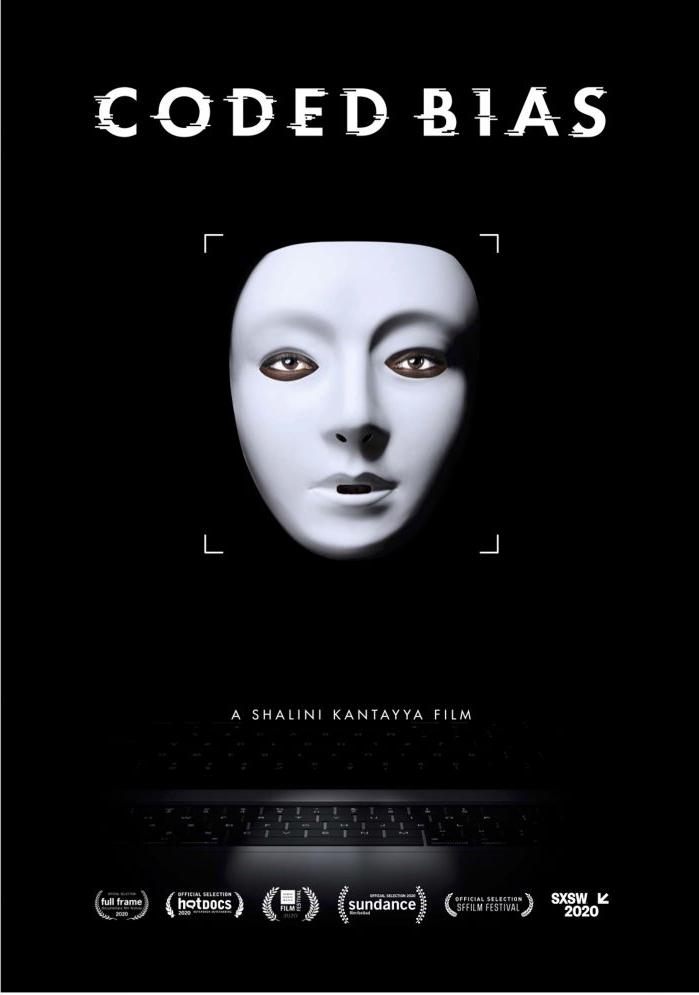

- Judul Film: Coded Bias

- Genre: Dokumenter

- Sutradara: Shalini Kantayya

- Rilis: Januari 2020 (Sundance)

- Durasi: 90 menit

Coded Bias tampaknya bakal melampaui capaian Catching the Sun. Coded Bias telah memenangi gelar film dokumenter terbaik pada Calgary International Film Festival dan nominasi pada Sundance Film Festival. Film dokumenter ini dianggap berhasil menunjukkan efek-efek buruk kebergantungan masyarakat modern kepada algoritme.

Di Amerika Serikat, yang menjadi rumah bagi enam dari sembilan korporasi global yang mengembangkan AI (tiga sisanya merupakan perusahaan asal China), perangkat-perangkat lunak yang memanfaatkan teknologi ini telah memengaruhi banyak aspek kehidupan masyarakat, mulai dari layanan pendidikan, kesehatan, ketenagakerjaan, hingga hukum. Film ini memperlihatkan kasus-kasus nyata bagaimana warga kelas bawah, kulit berwarna, dan perempuan terdiskriminasi dan termarginalisasi oleh teknologi tersebut. Algoritme berkerja menyingkirkan mereka dari layanan kesehatan, membuat mereka ditolak di perusahaan-perusahaan, menyisihkan guru-guru terbaik hanya karena mereka bukan pria kulit putih, dan melabeli mereka “berisiko tinggi” bagi keamanan hanya karena mereka berkulit hitam, Hispanik, atau memiliki sejarah orang tua yang pernah bermasalah dengan hukum.

Dalam dokumenter ini, kita bisa merasakan adanya tarik-menarik antara dalih keamanan nasional dan ketertiban sosial (tanpa mengenyampingkan dalih komersial) dengan hak kebebasan dan kesetaraan. Atas nama dalih yang pertama, mesin-mesin pintar itu memilah dan menetapkan kelompok-kelompok masyarakat yang “berisiko tinggi”. Pada ujungnya proses kerja matematika algoritmis seperti ini akan makin meminggirkan kelompok masyarakat yang kurang beruntung secara ekonomi—dan entah mengapa ini berkaitan erat dengan profil para raksasa teknologi di balik mesin-mesin itu.

Hal ini diperparah dengan fakta mesin-mesin pintar itu kerap salah identifikasi. Di Inggris, perangkat lunak pengenalan dan analisis wajah yang digunakan kepolisian telah melakukan kesalahan 2.400 kali. Warga kulit berwarna secara serampangan dicegat di jalanan atau ditahan hanya karena AI mengidentifikasi mereka sebagai “kriminal” dan “teroris”.

Negara bisa berargumen mesin itu toh pernah sukses mengidentifikasi satu atau dua penjahat. Tapi, apa yang bisa mereka lakukan terhadap dampak yang telah ditimbulkan mesin itu bagi mereka yang salah diidentifikasi? Apakah ada mekanisme pertanggungjawaban dan rehabilitasi? Jawabannya, tidak ada.

Mesin-mesin itu dibuat oleh perusahaan swasta yang berkeras merahasiakan model algoritmenya. Lalu, mesin itu digunakan oleh negara tanpa persetujuan publik berupa regulasi (undang-undang). Ketika mesin itu bersalah, negara, dan apalagi perusahaan itu, tak mau bertanggung jawab atau setidaknya memberi respons. Perusahaan teknologi yang berambisi membuat mesin-mesin cerdas itu seringkali—dan ini mudah kita temukan—membatasi “sentuhan fisik” dengan konsumennya dan publik secara umum. Tahukah Anda di mana kita bisa mengeluhkan layanan Google atau Amazon selain melalui surat elektronik atau layanan dalam jaringan?

Kalaupun mesin-mesin itu 100 persen akurat, ada persoalan berikutnya. Bukankah kita, sebagai manusia merdeka, memiliki hak untuk menolak data (termasuk data biometrik) kita ditambang serampangan, tanpa sepengetahuan dan persetujuan kita? Pertanyaan ini makin relevan jika kita membayangkan mesin-mesin pemindai dan penganalisis data biometrik dipasang pada jutaan jaringan CCTV di suatu kota, negara, atau bahkan di seluruh dunia. Untuk mengambil sampel sidik jari dan DNA saja, polisi membutuhkan dalih legal. Tapi, raksasa-raksasa teknologi (berikut produknya yang berbasiskan mahadata) sama sekali belum diatur dalam legislasi.

Menyaksikan Coded Bias, saya seakan merasakan zaman perbudakan kembali hadir. Manusia dicap, dilabeli, dan di-tag layaknya budak belian. Perbedaannya, pada masa kini, semua itu dilakukan secara subtil, sopan, dan bahkan dipuja-puji: keren! Perhatikan bagaimana kita sekarang tanpa sadar menyerahkan data-data pribadi melalui penggunaan media sosial secara berlebihan. Kita dengan sukacita mengunggah setiap informasi tentang diri, keluarga, dan sahabat kita, dari foto, data perjalanan, data kependudukan, hingga kebiasaan kita sehari-hari.

Lalu, bagaimana semua ini bisa terjadi? Coded Bias menjelaskannya dengan jernih dan sadar-kelas.

Mahadata, algoritme, atau matematika pada dasarnya netral. Tapi, manusia di balik semua itu belum tentu bebas bias. Film ini menunjukkan mayoritas punggawa raksasa-raksasa teknologi ini adalah pria kulit putih. Hanya 14 persen warga non-kulit putih terwakili dalam komunitas “Silicon Valley” (istilah ini tak hanya merujuk pada suatu wilayah tertentu di California). Merekalah para penguasa dan pengendali kode-kode kehidupan modern.

Situasi tersebut menghadirkan relasi-kuasa yang timpang atau asimetris. Tak ada kekuatan penyeimbang. Tak ada mekanisme pengawasan akuntabilitas atau pertanggungjawaban terkait apa yang mereka lakukan dan kerjakan. Apalagi, mesin-mesin mereka kini makin memengaruhi hampir setiap embusan napas dan denyut nadi masyarakat modern.

Apakah mereka sengaja menyuntikkan data atau menciptakan permodelan dan algoritme yang bias? Di bagian awal, film ini mengesankan demikian karena, secara statistik, teknologi ini hanya dikendalikan segelintir orang dari kelompok homogen.

Jika biang masalahnya adalah man behind the machine, bukankah problem ini bisa diperbaiki? Bukankah kita bisa menciptakan algoritme bebas bias?

Coded Bias mengatakan persoalannya bukan semata itu. Algoritme merupakan sistem yang bekerja mencerna informasi historis untuk memprediksi masa depan. Machine learning adalah sistem yang mengkalkulasi apa yang akan kita lakukan berdasarkan apa yang telah kita lakukan. Di sinilah, sisi lain persoalan ini. AI dan machine learning mereplika apa yang pernah manusia lakukan. Mesin-mesin ini hanya merespons berdasarkan respons yang pernah dilakukan manusia.

Oleh karena itu, mesin-mesin “cerdas” itu kerap bekerja tak sesuai yang diharapkan. Mereka menjadi black box bahkan bagi para penciptanya sendiri. Anda mungkin mengingat kasus pada 2016 ketika Microsoft meluncurkan akun bot di Twitter bernama Tay. Mesin AI itu dinonaktifkan hanya 16 jam setelah diluncurkan karena berkicau rasis, fasis, dan anti-perempuan. Chatterbot itu hanya mereplika respons-respons akun-akun rasis, misoginis, dan intoleran yang memang mendominasi percakapan di linimasanya.

Kecerdasan mesin-mesin itu boleh jadi tajam tapi empatinya tumpul. Mereka bekerja secara matematis, dan bukan secara etis. Etika dan empati bukanlah sesuatu yang bisa disuntikkan ke dalam data dan algoritme. Keduanya tak pernah bisa diformulasikan menjadi kode-kode atau rumus-rumus rigid. Keduanya merupakan penghayatan jiwa yang memampukan manusia melakukan abstraksi atas segala hal empiris. Keduanya merupakan kelebihan manusia, yang menurut saya tak akan pernah bisa ditandingi oleh AI.

Mesin-mesin itu tentu saja bisa membantu manusia dalam banyak aspek kehidupan. Mereka bisa sangat efisien dalam membantu pekerjaan kita. Tapi, percaya sepenuhnya bahwa mesin-mesin itu bisa menyelesaikan problem kemanusiaan adalah kekeliruan besar. Percaya buta kepada kerja algoritme tak akan pernah melejitkan peradaban manusia ke level yang lebih tinggi.

Pada bagian akhir film ini, sosiolog asal Turki, Zeynep Tufekci, mengemukakan kisah Stanislav Petrov, seorang perwira di militer Uni Soviet. Petrov bertugas memantau sistem pertahanan udara Soviet.

Pada 26 September 1983, sistem peringatan dini anti-nuklir di markasnya mengidentikasi serangan rudal nuklir Amerika Serikat ke Soviet. Di momen seperti itu, sesuai prosedur, Petrov seharusnya melapor ke atasannya—yang berwenang memberi respons balasan atas serangan itu. Tapi, dia merahasiakannya meskipun tahu negara, bangsa, dan orang-orang yang dia cintai mungkin segera musnah. Nuraninya berujar, “Setidaknya kami tidak membunuh mereka.”

Keputusan etis—bukan otomatis—Petrov telah menyelamatkan dunia dari perang nuklir. Sistem komputer pertahanan udara soviet itu kemudian terbukti membunyikan alarm palsu. Kisah ini baru diungkap ke publik dunia pada 1998.

Kisah Petrov menunjukkan kepada kita betapa sangat berharganya nurani kemanusiaan—sesuatu yang tak bisa direplikasi AI. “Menjadi sangat efisien, selalu melakukan apa yang diperintahkan dan diprogramkan, itu kadang sangat tidak manusiawi. Menolak patuh kadang adalah hal yang benar untuk dilakukan,” kata Tufekci.

Coded Bias sangat layak Anda tonton ketika pada hari-hari ini tak sedikit orang yang tergila-gila dengan algoritme, AI, dan machine learning. Seolah semua itu adalah masa depan kemanusiaan.

Film ini tak hanya menampilkan Buolamwini tapi juga sederet nama yang berkecimpung dalam bidang ini. Mereka antara lain Meredith Broussard (saintis data dan penulis Artificial Unintelligence), Cathy O’Neil (saintis data, matematikawan, dan penulis Weapons of Math Destruction), Sofiya Nobel (saintis data dan penulis Algorithms of Oppression), Zeynep Tufekci (sosiolog dan penulis Twitter and tear gas), serta Timnit Gebru (saintis komputer dan bekas pemimpin Tim Etika AI Google).

Dalam sejumlah wawancara dengan media, Kantayya mengatakan sumber-sumber filmnya yang hampir semua perempuan non-kulit putih adalah suatu kebetulan belaka. Merekalah yang berani berbicara menantang hegemoni AI dalam kehidupan manusia saat ini.

Menempuh jalan tersebut bukan tanpa risiko. Mereka bisa saja dicoret dari daftar penerima pendanaan proyek penelitian karena sebagian besar pendonor bidang ini adalah para raksasa perusahaan teknologi. Gebru telah merasakan itu. Pada Desember 2020, dia dipecat Google.

Film ini menurut saya setidaknya menyampaikan dua pesan. Pertama, mesti ada keterlibatan besar publik dalam menentukan penggunaan AI. Salah satu caranya adalah dengan meregulasi pemanfaatan teknologi ini. Regulasi ini bisa melahirkan semacam badan pengawas, seperti yang kita lakukan pada makanan dan obat-obatan. Kedua, dan ini yang menurut saya lebih penting, jangan pernah kita memercayakan sepenuhnya seluruh aspek kehidupan kita kepada mesin.[]